Zawartość

- Big Data jest nieustrukturyzowany lub częściowo ustrukturyzowany

- Przechowywanie dużych zbiorów danych nie ma sensu, jeśli nie możemy ich przetworzyć

- Jak Hadoop rozwiązuje problem Big Data

- Business Case dla Hadoop

Na wynos:

Hadoop może pomóc rozwiązać niektóre duże wyzwania dużych danych.

Duże dane są ... no cóż ... duże! Dokładnie, ile danych można zaklasyfikować jako duże zbiory danych, nie jest bardzo jasne, więc nie dajmy się wciągnąć w tę debatę. W przypadku małej firmy, która jest przyzwyczajona do przetwarzania danych w gigabajtach, 10 TB danych byłoby WIELKIE. Jednak dla firm takich jak i Yahoo petabajty są duże.Sam rozmiar dużych danych uniemożliwia (lub przynajmniej wygóruje) przechowywanie ich w tradycyjnym magazynie, takim jak bazy danych lub konwencjonalne filtry. Mówimy o koszcie przechowywania gigabajtów danych. Korzystanie z tradycyjnych filtrów pamięci masowej może kosztować dużo pieniędzy do przechowywania dużych zbiorów danych.

Tutaj dobrze przyjrzyj się big data, jej wyzwaniom i temu, jak Hadoop może pomóc je rozwiązać.Po pierwsze, największe wyzwania dużych zbiorów danych.

Big Data jest nieustrukturyzowany lub częściowo ustrukturyzowany

Wiele dużych zbiorów danych jest nieustrukturyzowanych. Na przykład dane dziennika strumienia kliknięć mogą wyglądać następująco:znacznik czasu, identyfikator_użytkownika, strona, strona odsyłająca

Brak struktury sprawia, że relacyjne bazy danych nie nadają się do przechowywania dużych zbiorów danych. Ponadto niewiele baz danych radzi sobie z przechowywaniem miliardów wierszy danych.

Przechowywanie dużych zbiorów danych nie ma sensu, jeśli nie możemy ich przetworzyć

Przechowywanie dużych danych jest częścią gry. Musimy go przetworzyć, aby wydobyć z niego inteligencję. Tradycyjne systemy przechowywania są dość „głupie” w tym sensie, że po prostu przechowują bity. Nie oferują żadnej mocy obliczeniowej.Tradycyjny model przetwarzania danych ma dane przechowywane w klastrze pamięci, który jest kopiowany do klastra obliczeniowego w celu przetworzenia. Wyniki są zapisywane z powrotem w klastrze pamięci.

Ten model nie działa jednak dobrze w przypadku dużych zbiorów danych, ponieważ kopiowanie tak dużej ilości danych do klastra obliczeniowego może być zbyt czasochłonne lub niemożliwe. Więc jaka jest odpowiedź?

Jednym z rozwiązań jest przetwarzanie dużych danych w miejscu, na przykład w klastrze pamięci, który podwaja się jako klaster obliczeniowy.

Jak widzieliśmy powyżej, duże zbiory danych wymykają się tradycyjnemu przechowywaniu. Jak więc obsługiwać duże zbiory danych?

Jak Hadoop rozwiązuje problem Big Data

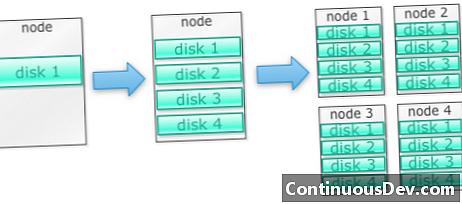

Hadoop został zbudowany do działania na klastrze maszynZacznijmy od przykładu. Powiedzmy, że musimy przechowywać wiele zdjęć. Zaczniemy od jednego dysku. Kiedy przekroczymy pojedynczy dysk, możemy użyć kilku dysków ułożonych w stos na komputerze. Kiedy zmaksymalizujemy wszystkie dyski na jednym komputerze, musimy zdobyć kilka komputerów, z których każdy ma kilka dysków.

Właśnie tak zbudowano Hadoop. Hadoop został zaprojektowany do pracy na klastrze maszyn od samego początku.

Klastry Hadoop skalują się w poziomie

Więcej pamięci i mocy obliczeniowej można uzyskać, dodając więcej węzłów do klastra Hadoop. Eliminuje to potrzebę kupowania coraz mocniejszego i droższego sprzętu.

Hadoop może obsługiwać nieustrukturyzowane / częściowo ustrukturyzowane dane

Hadoop nie wymusza schematu przechowywanych danych. Może obsługiwać dowolne i binarne dane. Dzięki temu Hadoop może łatwo trawić wszelkie nieustrukturyzowane dane.

Klastry Hadoop zapewniają przechowywanie i przetwarzanie danych

Przekonaliśmy się, że posiadanie oddzielnych klastrów pamięci i przetwarzania nie jest najlepszym rozwiązaniem dla dużych zbiorów danych. Klastry Hadoop zapewniają jednak przechowywanie i przetwarzanie rozproszone w jednym.

Business Case dla Hadoop

Hadoop zapewnia przechowywanie dużych danych po rozsądnych kosztach

Przechowywanie dużych danych przy użyciu tradycyjnej pamięci masowej może być kosztowne. Hadoop jest zbudowany na sprzęcie towarowym, więc może zapewnić dość duże miejsce do przechowywania za rozsądną cenę. Hadoop został użyty w terenie w skali petabajtów.

Jedno z badań przeprowadzonych przez Clouderę sugerowało, że przedsiębiorstwa zwykle wydają około 25 000 do 50 000 USD na terabajt rocznie. Dzięki Hadoop koszt ten spada do kilku tysięcy dolarów na terabajt rocznie. Ponieważ sprzęt staje się coraz tańszy, koszty te wciąż spadają.

Hadoop pozwala na przechwytywanie nowych lub więcej danych

Czasami organizacje nie przechwytują danych, ponieważ przechowywanie ich było zbyt kosztowne. Ponieważ Hadoop zapewnia przechowywanie za rozsądną cenę, ten typ danych można przechwytywać i przechowywać.

Przykładem mogą być dzienniki kliknięć witryny. Ponieważ liczba tych dzienników może być bardzo duża, niewiele organizacji je przechwyciło. Teraz dzięki Hadoop można przechwytywać i przechowywać dzienniki.

Dzięki Hadoop możesz przechowywać dane dłużej

Aby zarządzać ilością przechowywanych danych, firmy okresowo usuwają starsze dane. Na przykład można przechowywać tylko dzienniki z ostatnich trzech miesięcy, a starsze dzienniki zostały usunięte. Dzięki Hadoop możliwe jest dłuższe przechowywanie danych historycznych. Umożliwia to wykonanie nowej analizy starszych danych historycznych.

Na przykład weź dzienniki kliknięć ze strony internetowej. Kilka lat temu dzienniki te były przechowywane przez krótki czas w celu obliczenia statystyk takich jak popularne strony. Teraz dzięki Hadoop można przechowywać te dzienniki kliknięć przez dłuższy czas.

Hadoop zapewnia skalowalne analizy

Przechowywanie wszystkich tych danych nie ma sensu, jeśli nie możemy ich przeanalizować. Hadoop zapewnia nie tylko rozproszoną pamięć masową, ale także rozproszone przetwarzanie, co oznacza, że możemy równolegle przetwarzać duże ilości danych. Struktura obliczeniowa Hadoop nazywa się MapReduce. MapReduce został sprawdzony w skali petabajtów.

Hadoop zapewnia bogatą analitykę

Natywny MapReduce obsługuje Javę jako podstawowy język programowania. Można również używać innych języków, takich jak Ruby, Python i R.

Oczywiście pisanie niestandardowego kodu MapReduce nie jest jedynym sposobem analizy danych w Hadoop. Dostępna jest mapa na wyższym poziomie. Na przykład narzędzie o nazwie Pig pobiera angielski, podobnie jak język przepływu danych, i tłumaczy je na MapReduce. Inne narzędzie, Hive, pobiera zapytania SQL i uruchamia je za pomocą MapReduce.

Narzędzia analizy biznesowej (BI) mogą zapewnić jeszcze wyższy poziom analizy. Istnieją również narzędzia do tego typu analiz.

Ta treść pochodzi z „Hadoop Illuminated” Mark Kerzner i Sujee Maniyam. Został udostępniony za pośrednictwem Creative Commons Uznanie autorstwa-Użycie niekomercyjne-Na tych samych warunkach 3.0 Unported.