Zawartość

- Definicja - Co oznacza Endian?

- Wprowadzenie do Microsoft Azure i Microsoft Cloud | W tym przewodniku dowiesz się, na czym polega przetwarzanie w chmurze i jak Microsoft Azure może pomóc w migracji i prowadzeniu firmy z chmury.

- Techopedia wyjaśnia Endian

Definicja - Co oznacza Endian?

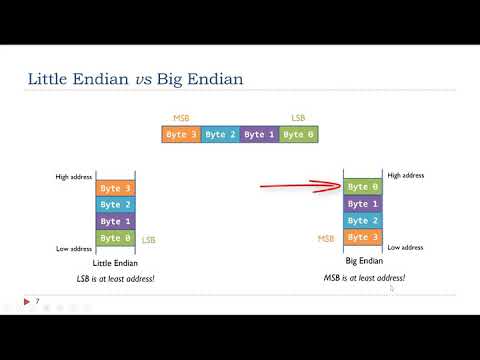

Endian odnosi się do tego, w jaki sposób kolejność bajtów w wartości wielobajtowej jest postrzegana lub obsługiwana. Jest to system porządkowania poszczególnych elementów słowem cyfrowym w pamięci komputera, a także opisywania kolejności transmisji danych bajtowych przez łącze cyfrowe. Słowa cyfrowe mogą być reprezentowane jako little-endian lub big-endian.

Wprowadzenie do Microsoft Azure i Microsoft Cloud | W tym przewodniku dowiesz się, na czym polega przetwarzanie w chmurze i jak Microsoft Azure może pomóc w migracji i prowadzeniu firmy z chmury.

Techopedia wyjaśnia Endian

Endian lub endianness to kolejność bajtów wybrana dla wszystkich obliczeń cyfrowych wykonanych w określonym systemie komputerowym i określa architekturę i podejście programistyczne niskiego poziomu, które należy zastosować w tym systemie. Chociaż dzisiaj endianność nie jest tak dużym problemem w zakresie kompatybilności systemu, ponieważ zawsze można ją obejść na niższych poziomach, dzięki czemu programiści i użytkownicy języków wysokiego poziomu są już oderwani od endianizmu systemu.

Termin endian został po raz pierwszy wprowadzony przez Danny'ego Cohena, a konkretnie dwa rodzaje endianizmu: little-endian i big-endian, aby opisać porządkowanie bajtów w znanym dokumencie politycznym i technicznym dotyczącym problemów z porządkowaniem bajtów w 1980 roku. termin z powieści Jonathana Swifta z 1726 r. „Podróże Guliwera”, w której wybuchła wojna domowa nad tym, który koniec jajka powinien zostać złamany jako pierwszy, mały czy duży koniec.

Świat komputerów jest nadal podzielony między dużą i małą endianizm, chociaż nie ma już wyraźnych zalet ani wad między nimi. Przemysł mikroprocesorowy podążył w kierunku little-endian, ponieważ korzysta z niego szeroko stosowana architektura Intel x86. Ale big-endian jest uważany za porządek bajtów sieciowych, ponieważ pakiet protokołu internetowego (IP), czyli IPv4 / 6, TCP i UDP, korzysta z tego. Jednak biorąc pod uwagę ich różnice, systemy komputerowe nadal działają, ponieważ różnica ta została już uwzględniona.